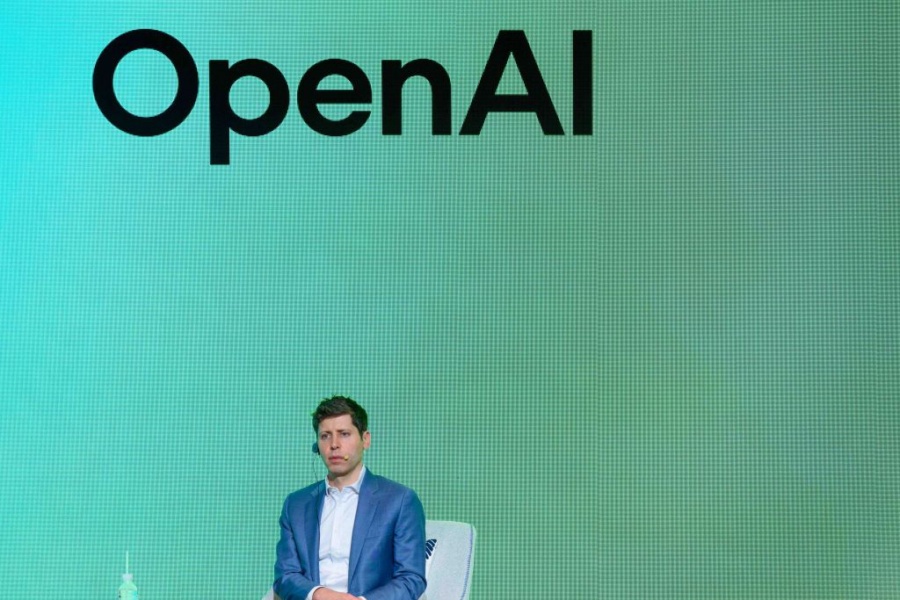

Image Credits:Kim Jae-Hwan/SOPA Images/LightRocket / Getty Images

اوپنایآی متعهد شد نتایج ارزیابیهای ایمنی هوش مصنوعی را بهطور منظمتر منتشر کند

اوپنایآی برای افزایش شفافیت در زمینه ایمنی هوش مصنوعی، متعهد شده است نتایج ارزیابیهای داخلی مدلهای خود را بهطور منظمتر و از طریق یک مرکز جدید به نام «مرکز ارزیابیهای ایمنی» منتشر کند.

۱۴۰۴/۰۲/۲۴

اوپنایآی در راستای افزایش شفافیت، «مرکز ارزیابیهای ایمنی» را راهاندازی کرده تا نتایج تستهای داخلی ایمنی مدلهای هوش مصنوعی خود را بهطور مستمر منتشر کند. این تستها شامل مواردی مانند تولید محتوای مضر و توهمات میشوند. این اقدام در پی انتقادها از رویکرد شرکت به ایمنی و مسائل اخیر مرتبط با مدل GPT-4o صورت میگیرد.

اوپنایآی (OpenAI) اعلام کرده است که در راستای افزایش شفافیت، قصد دارد نتایج ارزیابیهای داخلی ایمنی مدلهای هوش مصنوعی خود را بهطور منظمتر منتشر کند.

این شرکت روز چهارشنبه «مرکز ارزیابیهای ایمنی» (Safety evaluations hub) را راهاندازی کرد. این صفحه وب، امتیازات مدلهای اوپنایآی را در تستهای مختلف برای مواردی نظیر تولید محتوای مضر، جیلبریکها (Jailbreaks) و توهمات (Hallucinations) نشان میدهد. اوپنایآی اعلام کرده که از این مرکز برای به اشتراک گذاشتن معیارها بهصورت «مستمر» استفاده خواهد کرد و قصد دارد با «بهروزرسانیهای اصلی مدلها» این مرکز را بهروز کند.

اوپنایآی در پستی وبلاگی نوشت: «همانطور که علم ارزیابی هوش مصنوعی تکامل مییابد، هدف ما به اشتراک گذاشتن پیشرفتهایمان در توسعه راههای مقیاسپذیرتر برای اندازهگیری قابلیت و ایمنی مدلها است. با به اشتراک گذاشتن زیرمجموعهای از نتایج ارزیابیهای ایمنی خود در اینجا، امیدواریم این کار نه تنها درک عملکرد ایمنی سیستمهای اوپنایآی را در طول زمان آسانتر کند، بلکه از تلاشهای جامعه برای افزایش شفافیت در این زمینه نیز حمایت نماید.»

اوپنایآی همچنین گفته است که ممکن است بهمرور زمان ارزیابیهای دیگری را به این مرکز اضافه کند.

در ماههای اخیر، اوپنایآی به دلیل گزارشهایی مبنی بر عجله در تست ایمنی برخی مدلهای اصلی و عدم انتشار گزارشهای فنی برای برخی دیگر، خشم برخی کارشناسان اخلاق را برانگیخته است. سم آلتمن، مدیرعامل این شرکت، نیز متهم شده که پیش از برکناری کوتاهش در نوامبر ۲۰۲۳، مدیران اجرایی اوپنایآی را در مورد بررسیهای ایمنی مدلها گمراه کرده است.

اواخر ماه گذشته، اوپنایآی مجبور شد بهروزرسانی پیشفرض مدل پلتفرم ChatGPT، یعنی GPT-4o، را بازگرداند. این اقدام پس از آن صورت گرفت که کاربران گزارش دادند مدل به شیوهای بیش از حد تأییدکننده و موافق پاسخ میدهد. شبکه X (توئیتر سابق) با اسکرینشاتهایی پر شد که نشان میداد ChatGPT انواع تصمیمها و ایدههای مشکلساز و خطرناک را تأیید میکند.

اوپنایآی اعلام کرد که چندین اصلاح و تغییر را برای جلوگیری از حوادث مشابه در آینده پیادهسازی خواهد کرد، از جمله معرفی یک «فاز آلفا»ی انتخابی (opt-in “alpha phase”) برای برخی مدلها که به کاربران خاصی از ChatGPT اجازه میدهد مدلها را قبل از عرضه نهایی تست کرده و بازخورد ارائه دهند.

منبع: تککرانچ